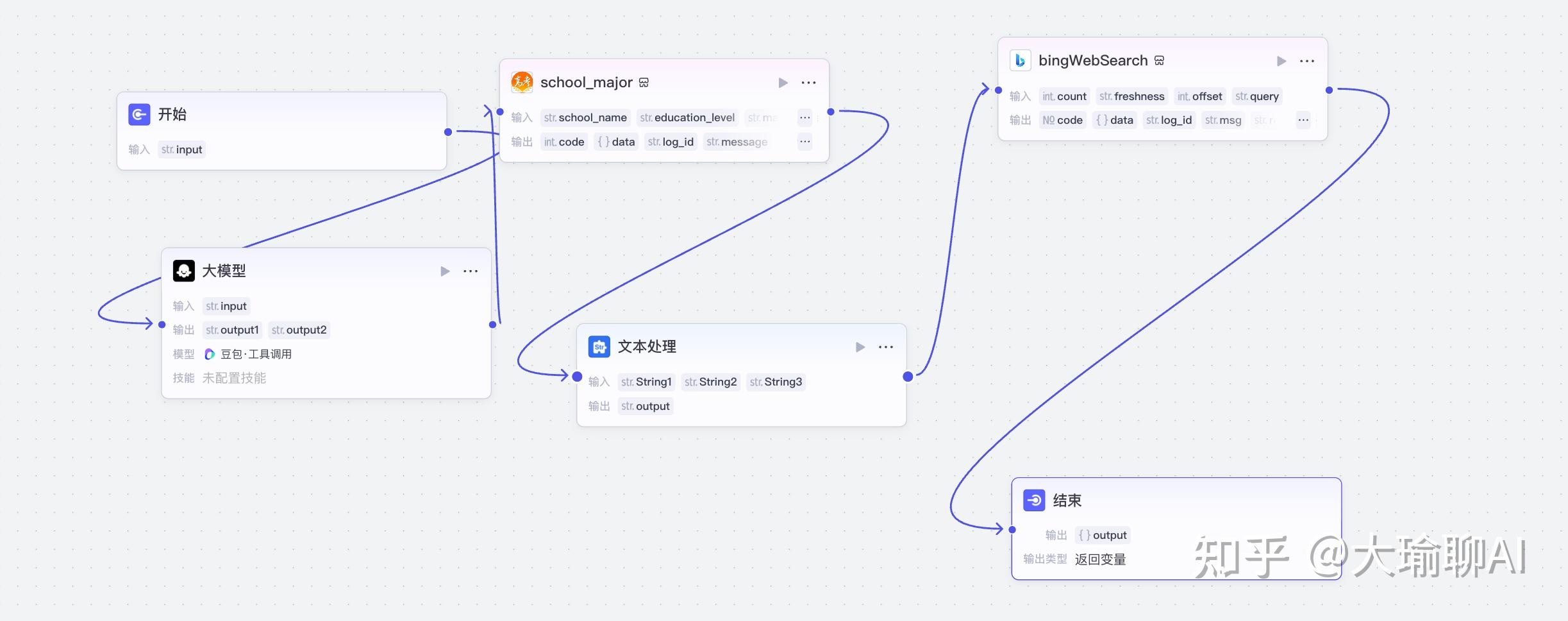

dify n8n coze llamaindex langchain 有可比性吗?

你满怀激情地打开Coze,准备搭建一个令人惊艳的AI工作流。几个小时过去了,你却发现自己陷入了一个个"不支持"的深坑:

"抱歉,这个插件暂时不能用..." "对不起,这个功能国内版不支持..." "很遗憾,我们不支持MCP协议..."

我懂那种抓狂的感觉。毕竟我也曾是Coze的忠实拥趸,直到有一天我发现...它的围墙实在太高了!

Coze的三大痛点

1、"围墙花园"效应 — 所有内容都被锁在Coze的官方服务器里,你的创意被锁在别人的城堡里,这感觉好吗?

2、缺乏*MCP*支持 — MCP(模型调用协议)已经成为行业标准,极大简化了大模型调用难度。然而Coze至今不支持,这就像是2025年还在用2G网络...

3、割裂的生态系统 — 国内版和国际版是两套完全不同的体系。

在无数次的挫败感后,我决定寻找新出路,然后我发现了N8n这个宝藏工具!

n8n是什么?

N8n是什么?简单来说,它就是一个帮你自动化重复任务的神器,可以将不同的软件和服务无缝连接起来。

但与Coze不同的是,N8n真正尊重你的自由和创造力!

为什么N8n让我爱不释手?

1、完全可本地部署 — 你的数据,你做主!没有莫名其妙的限制!

2、1000+插件生态 — 从专业的Jenkins到日常的Notion,应有尽有。

3、开放友好的社区 — 真正理解开发者需求的地方

5分钟上手N8n(真的这么简单!)

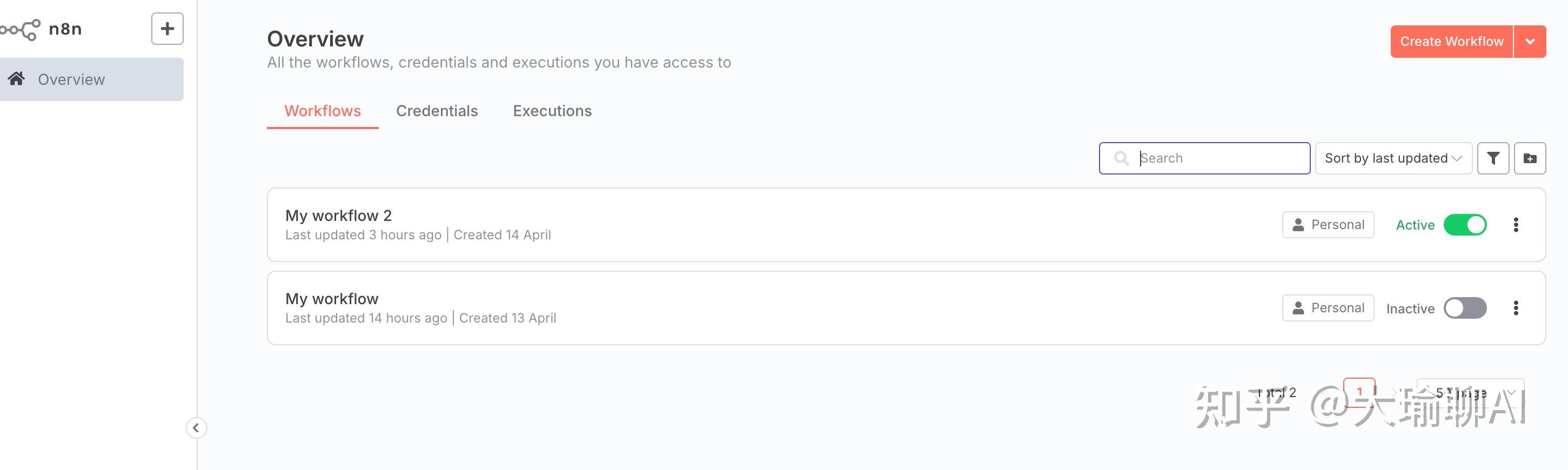

n8n的项目部署还是很简单的,只要电脑安装nodejs就可以。git地址下载:

https://github.com/n8n-io/n8n

具体的执行命令就两行:

git clone git@github.com:n8n-io/n8n.git

cd n8n

npx n8n

然后打开:localhost:5678 你就会看到热乎乎的滚烫页面了。

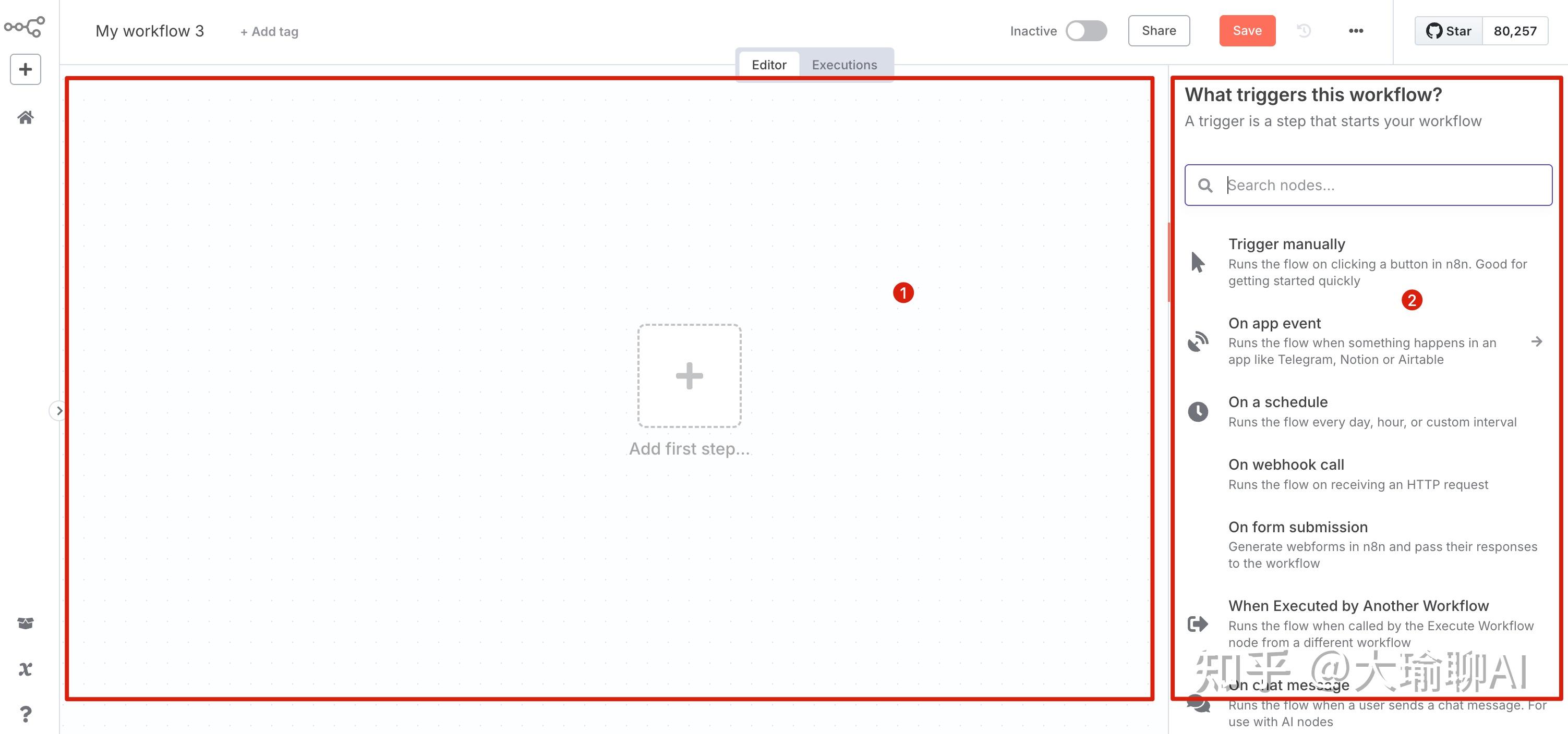

点击“create workflow”就进入我们的编辑窗口了。

右侧区域是组件区域,包含大模型回话的工具、组件调用的工具、以及具体的mcp组件。

左侧部分是面板区域,可以对节点进行编排以及处理。

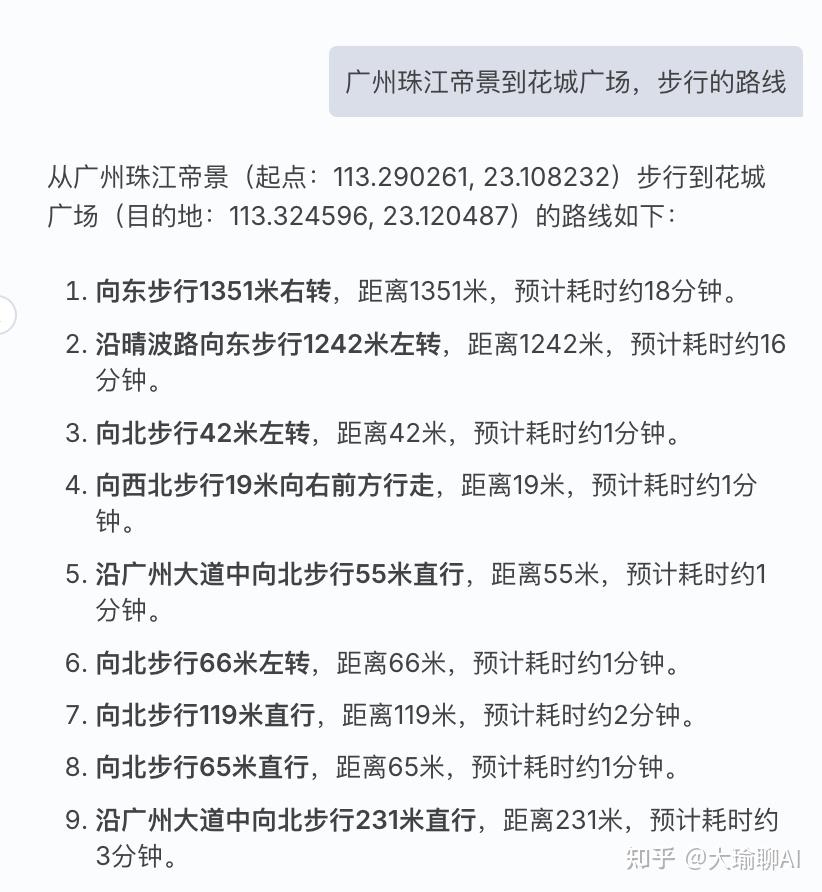

实战案例:N8n + 高德MCP = 本地化AI应用

光说不练假把式,来看看我如何用N8n集成高德MCP,打造一个完全本地化的AI应用。

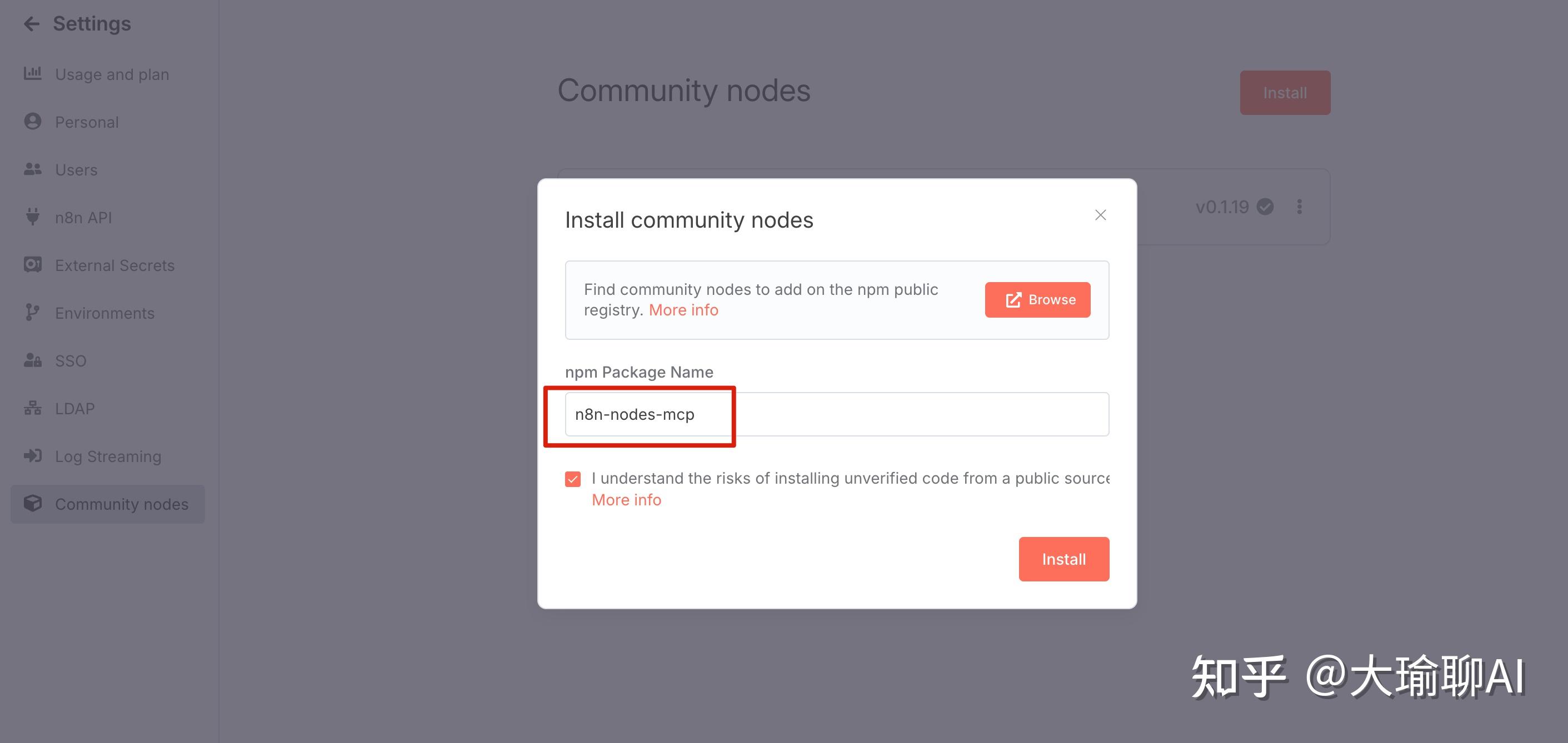

首先我们需要在设置中,添加n8n-nodes-mcp的服务节点。因为mcp目前官方并未支持,需要安装社区版本的服务节点。

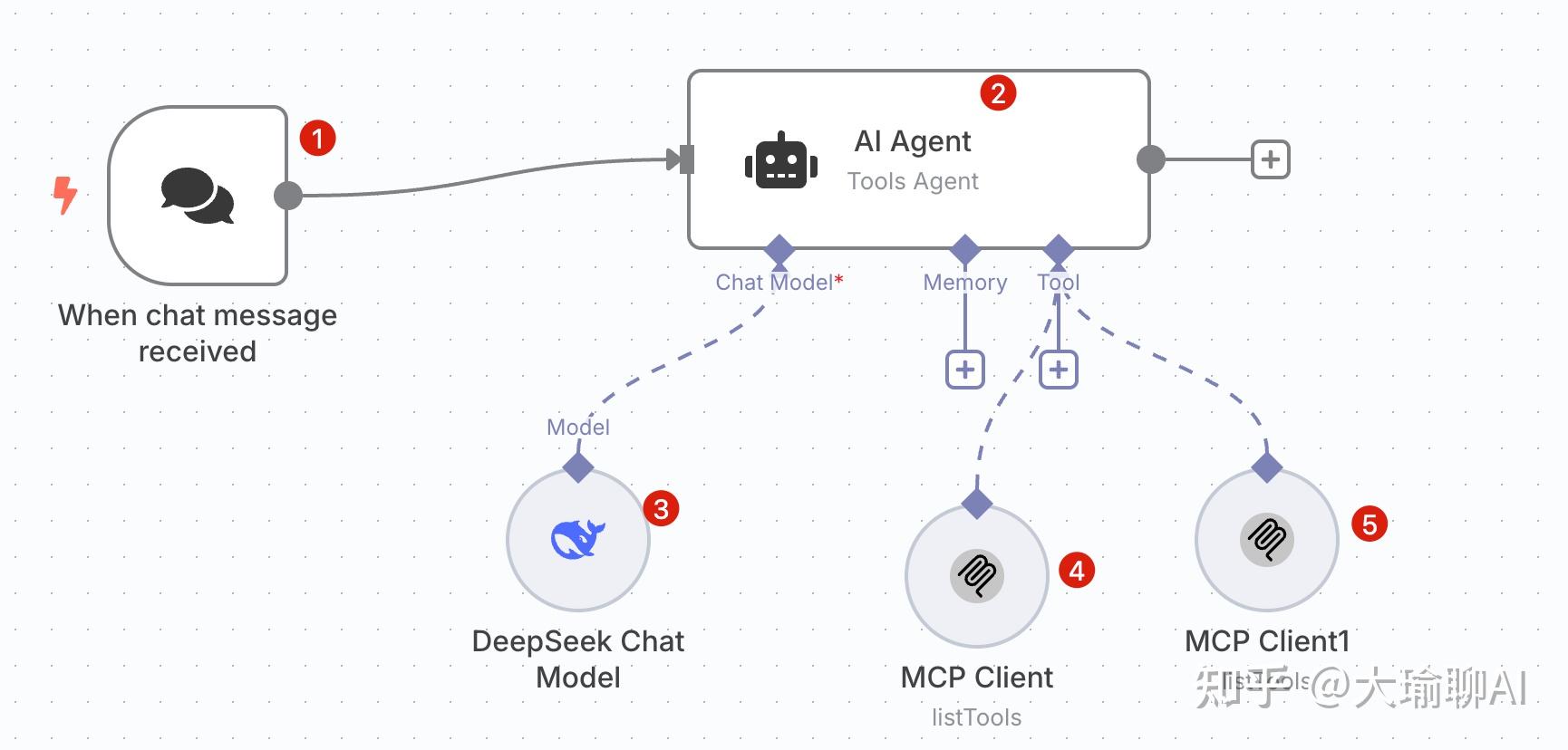

接下来就是具体的组件编排工作了。我们一共用到下面5个组件,下面我就描述下每个组件的关系。

组件1:chat trigger,对话的起点,拖入即用。

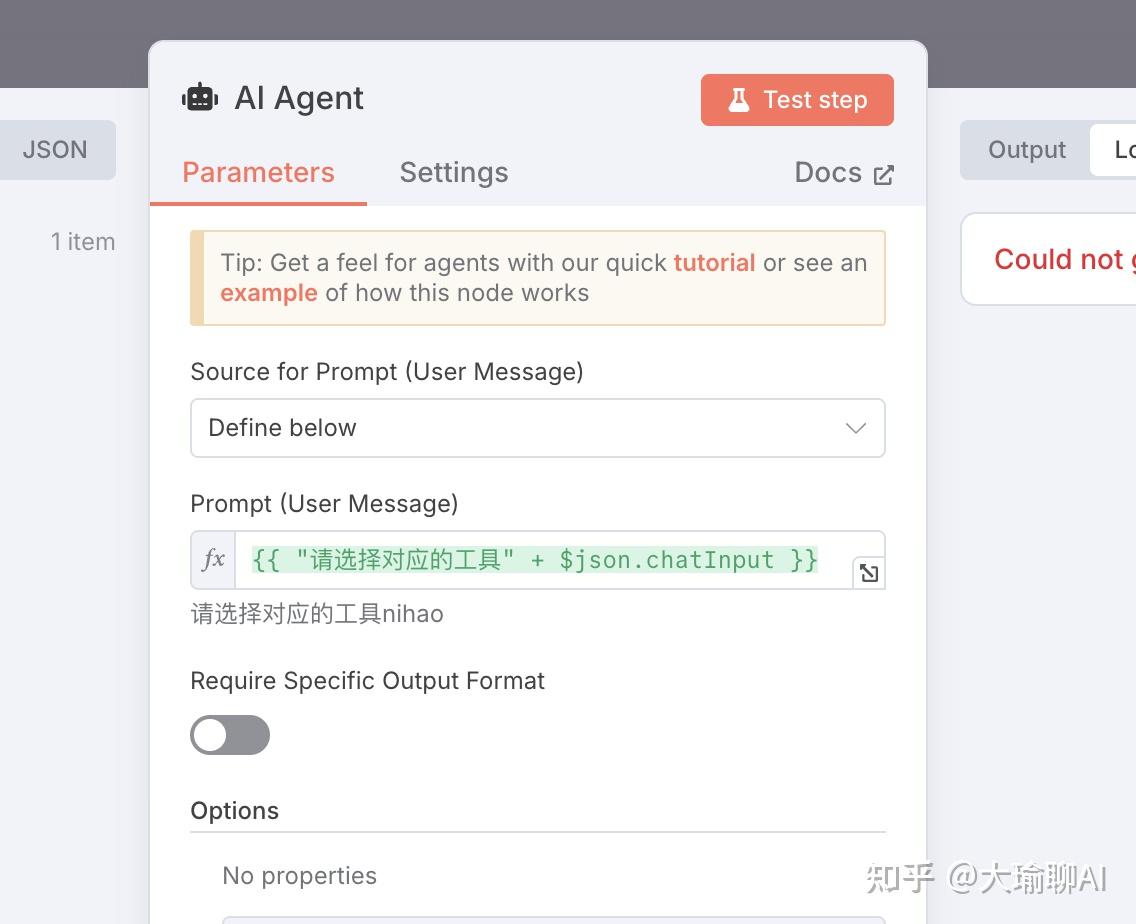

组件2:AI agent,核心大脑,在这里编写提示词,让AI理解用户意图

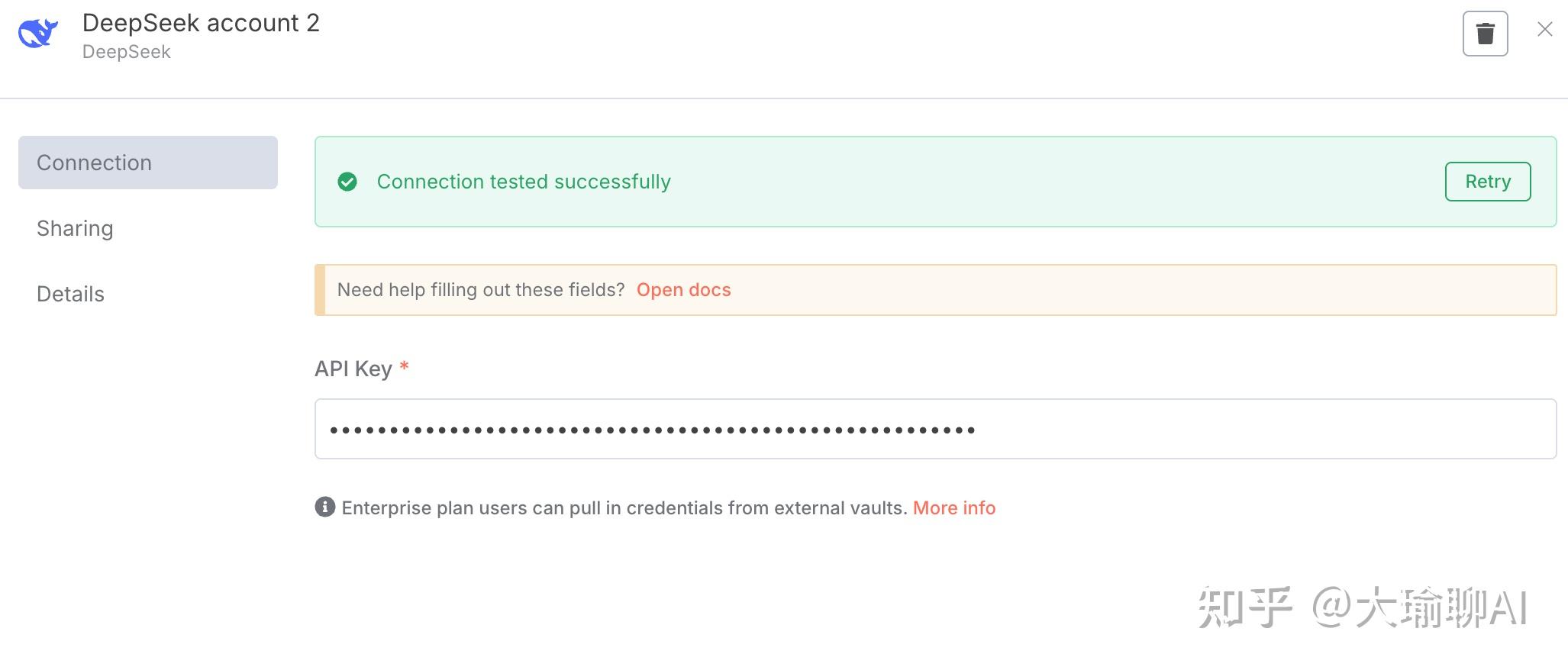

组件3:大模型选择,这里我们选择deepseek,仅仅需要配置下api-key即可。

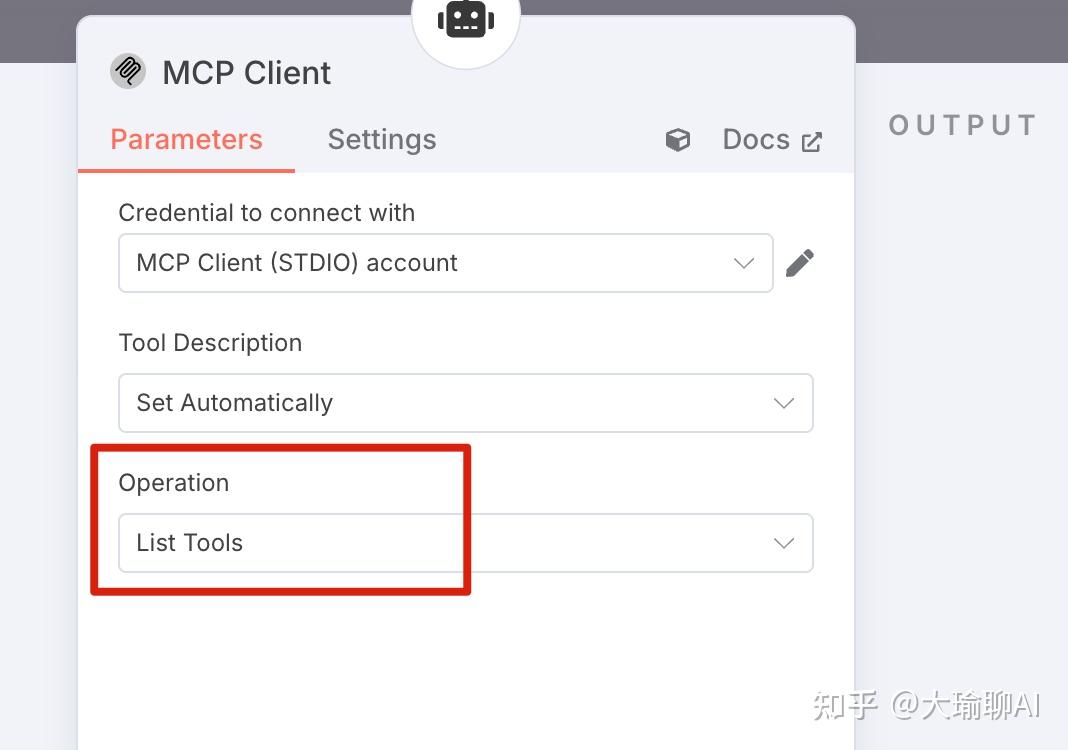

组件4:连接高德MCP的SSE接口(申请方法在我之前的文章有详细介绍)

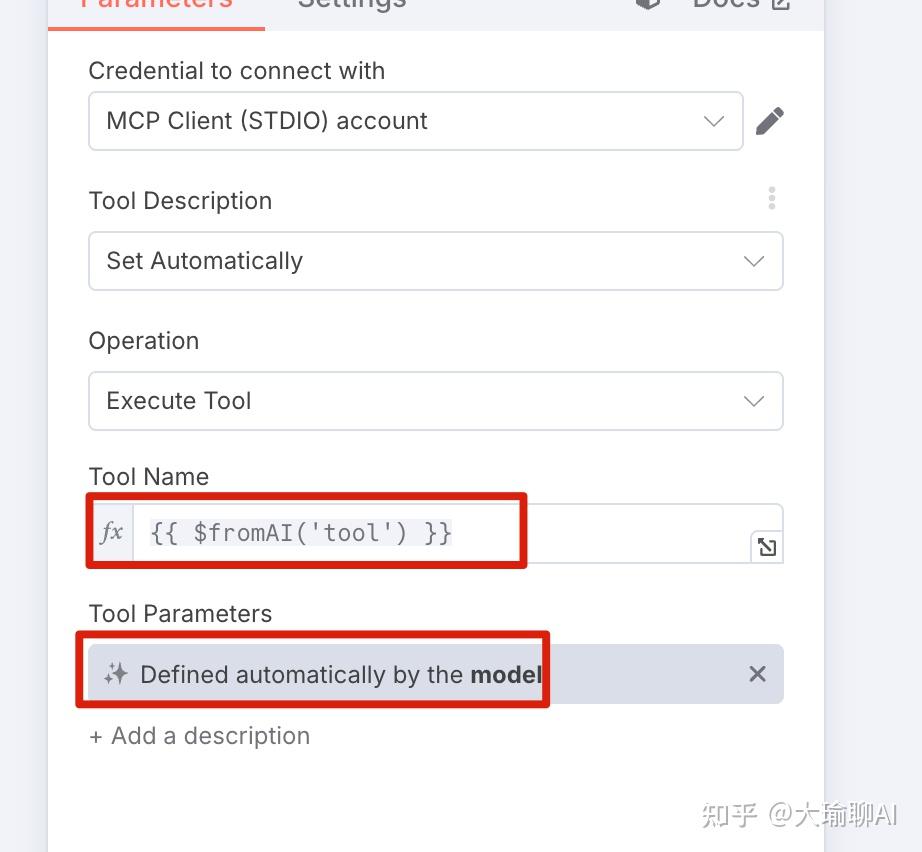

组件5:执行MCP服务,将Tool Name设为${{fromAI('tool')}},让模型自动选择合适的工具执行。

整个流程搭建下来只需10分钟,效果却出奇惊艳!

写在后面的话

N8n确实是个宝藏工具,特别适合喜欢掌控一切的开发者。

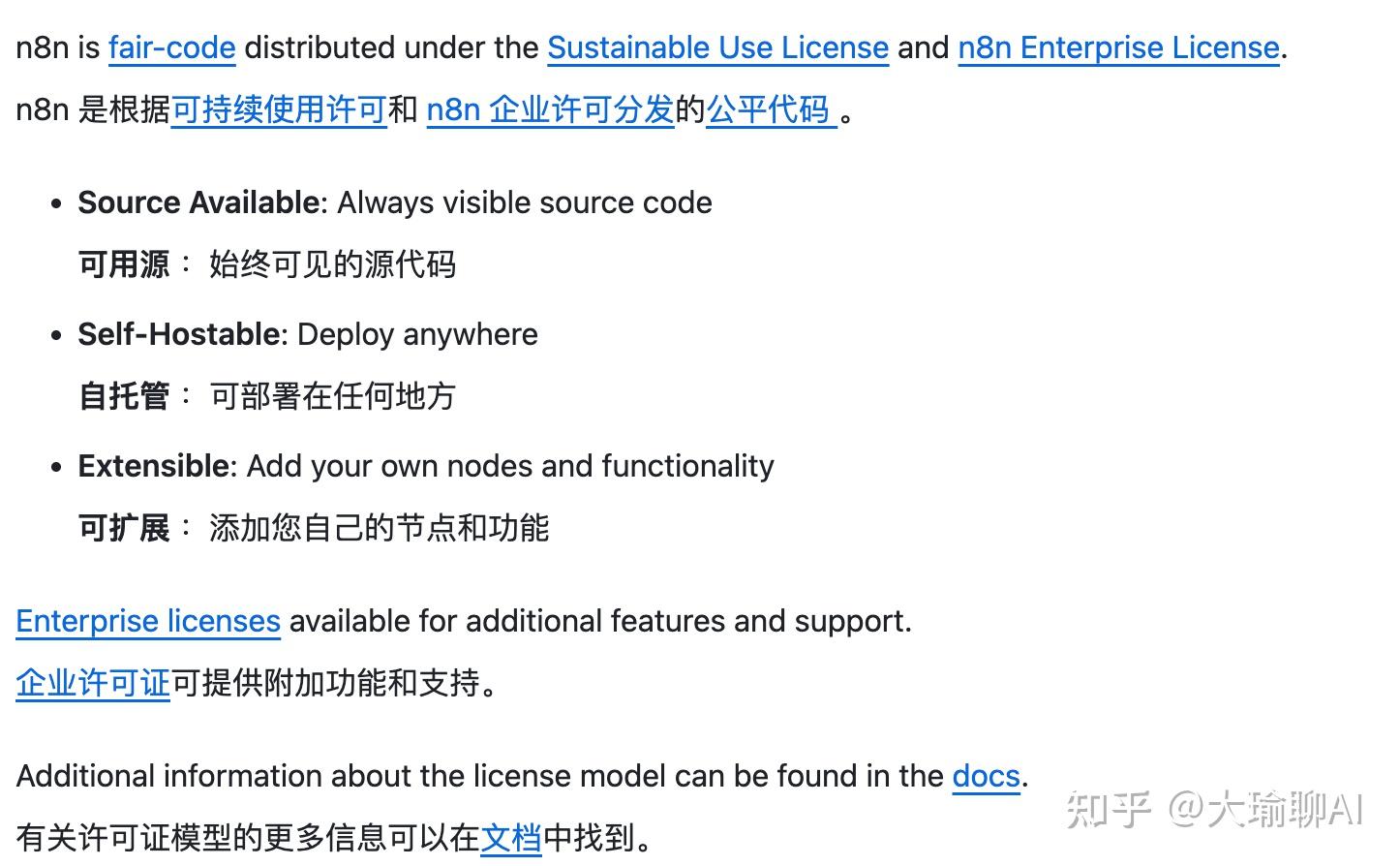

但坦白说,它的开源协议对企业用户不那么友好,如果你打算在公司使用,最好先咨询下法务。

我是大瑜,关注我,分享更多的AI知识和AI工具。